14 de mayo de 2018

L

Las limitaciones del aprendizaje profundo

por Pablo Rodríguez Canfranc

14 de mayo de 2018

por Pablo Rodríguez Canfranc

La popularidad del término deep learning o aprendizaje profundo despega en 2012 gracias a trabajos como el de los profesores de la Universidad de Toronto Alex Krizhevsky, lya Sutskever y Geoffrey E. Hinton ImageNet Classification with Deep Convolutional Neural Networks, que ponen en evidencia la capacidad de las redes neuronales para clasificar objetos. En este caso, los autores consiguieron que su sistema clasificara 1,2 millones de imágenes de alta resolución en 1.000 categorías distintas, dentro del concurso de algoritmos ImageNet Large Scale Visual Recognition Competition (ILSVRC).

Durante los últimos seis años el aprendizaje profundo se ha convertido en titular de periódicos y objeto de innumerables artículos en medios tecnológicos y generalistas, convirtiéndose en la técnica de moda de la inteligencia artificial. The New York Times llegó a afirmar en 2016 que el aprendizaje profundo estaba preparado para reinventar la ciencia computacional (The Great A.I. Awakening 1).

Sin embargo, hay científicos como Gary Marcus que rebajan las expectativas del deep learning, no negando su utilidad y valor, pero señalando sus limitaciones y la necesidad de combinarlo con otras técnicas de inteligencia artificial para que esta realmente pueda alcanzar todo su potencial. Marcus es experto en psicología cognitiva y profesor en la Universidad de Nueva York. Ha plasmado su visión sobre las limitaciones del aprendizaje profundo en el paper Deep Learning: A Critical Appraisal 2, que ha generado un encendido debate entre los expertos en inteligencia artificial desde que fue publicado en enero.

Su tesis es que el aprendizaje profundo ha cosechado grandes logros en campos como el reconocimiento del lenguaje natural, el reconocimiento de imágenes, la traducción y también juega un papel importante en el funcionamiento de numerosas aplicaciones de la inteligencia artificial que están desarrollándose en la actualidad, pero, a su juicio, la evolución del deep learning se está acercando a un muro.

Marcus divide su trabajo en cuatro partes: tras una introducción sobre el aprendizaje profundo y lo que realmente hace bien esta técnica, pasa a exponer las debilidades que presenta y los peligros que entraña el confundir su potencial y capacidades. Finalmente, propone lo que él considera que debería ser el camino de investigación en este campo.

Estableciendo un paralelismo con la neurología, las redes neuronales de la inteligencia artificial permiten generar sistemas que imitan el funcionamiento del cerebro en la forma en que este clasifica la información recibida, por ejemplo, identificando objetos en función de los rasgos que contienen. Se trata de programas que realizan sus diagnósticos o predicciones basándose en la probabilidad. Su forma de aprendizaje contempla la retroalimentación; en sucesivas vueltas reciben el grado de acierto de sus dictámenes y realizan las correcciones oportunas. Un sistema de prueba y error similar al que empleamos los humanos al realizar una tarea nueva. El concepto de aprendizaje profundo o deep learning hace referencia a que las redes neuronales tienen una estructura basada en numerosas capas, en general más de 10, aunque actualmente están en pruebas algunas con más de 100.

Gary Marcus afirma que el aprendizaje profundo es utilizado especialmente como un sistema de clasificación, de forma que la red neuronal debe decidir a qué categoría o grupo de categorías pertenece un determinado elemento. Por ejemplo, en el reconocimiento del lenguaje natural, la red debe asociar grupos de sonidos del habla humana con categorías como pueden ser palabras o fonemas. En el caso del reconocimiento de objetos, el sistema aprende a relacionar una serie de imágenes con sus etiquetas o categorías, por ejemplo, la imagen de un coche con la etiqueta “automóvil”.

Pero Marcus piensa que el alcance del deep learning es limitado, precisamente porque se alimenta de cantidades inmensas de información y esta es un bien escaso. En la medida en que un sistema se enfrente a un input del que no ha tenido un ejemplo previo, por ejemplo, una foto o una palabra, y se ve obligado a extrapolar en base a datos genéricos, los resultados que ofrezca pueden resultar más imprecisos. Puede ser, por ejemplo, una determinada pronunciación que un sistema de reconocimiento del lenguaje no tiene registrada y que le haga confundir una palabra o expresión por otra.

Es por ello, que Gary Marcus postula diez retos a los que se enfrenta el aprendizaje profundo en la actualidad.

1. El deep learning actual es un devorador de datos

A diferencia del cerebro humano, los algoritmos basados en el aprendizaje profundo carecen de mecanismos para aprender términos abstractos a través de la mera definición verbal y necesitan ser entrenados con millones de ejemplos. Ante situaciones o problemas donde los datos no están disponibles en grandes cantidades, el aprendizaje profundo puede no resultar la mejor solución.

2. El deep learning actual es muy superficial y ofrece pocas oportunidades de transferencia

Para Marcus, los sistemas actuales no comprenden realmente los conceptos y han sido entrenados para actuar en determinados escenarios o situaciones. Cuando se llevan a cabo los denominados tests de transferencia en los que el algoritmo es confrontado con escenarios que difieren, aunque sea ligeramente, de aquellos en los que ha sido entrenado, las soluciones que ofrece resultan superficiales.

3. El deep learning actual no puede tratar de forma natural con una estructura jerárquica

Las correlaciones que establecen este tipo de sistemas entre distintos elementos son llanas y no jerárquicas, como en una lista en la que cada elemento está al mismo nivel que los demás. Cuando se enfrentan con una estructura jerárquica, como por ejemplo una frase subordinada a otra, estos algoritmos pueden aproximarse de forma inadecuada al análisis.

Gary Marcus utiliza el ejemplo de una frase compleja. Los sistemas de reconocimiento del lenguaje basados en el aprendizaje profundo abordarán la frase como una secuencia de palabras. Sin embargo, en una frase como el adolescente que previamente atravesó el Atlántico estableció un record de vuelo alrededor del mundo, la cláusula principal sería el adolescente que estableció un record de vuelo alrededor del mundo, mientras que previamente atravesó el Atlántico estaría subordinada a la primera. Marcus duda que el sistema pueda reconocer esa jerarquía.

4. El deep learning actual choca con las inferencias abiertas

Los humanos cuando leemos un texto podemos inferir cosas de él que no están directamente referenciadas o solo parcialmente. Por ejemplo, adivinar las intenciones de un personaje determinado a través de un diálogo en el que las muestra de forma indirecta. El aprendizaje profundo consigue desenvolverse con éxito en situaciones en las que la solución está contenida en un texto, pero empieza a tener problemas cuando esta no es tan explícita, bien porque se combinen muchas frases, bien porque las frases sean explícitas, pero que hagan alusión a un trasfondo que no aparece en el fragmento de texto.

5. El deep learning actual no es lo suficientemente transparente

Generalmente, se habla de la opacidad de las redes neuronales, haciendo referencia a que son sistemas que analizan millones de parámetros para tomar decisiones cuyo funcionamiento concreto queda fuera del conocimiento de sus creadores. El funcionamiento de una red neuronal profunda se basa en miles de neuronas simuladas almacenadas en cientos de capas interconectadas. Algo excesivamente más opaco e inaccesible que cualquier código de programación convencional.

6. El deep learning actual no ha sido debidamente integrado con el conocimiento previo

Marcus afirma que la principal aproximación al aprendizaje profundo es hermenéutica, es decir, autocontenida y aislada de cualquier conocimiento potencialmente útil. El proceso suele consistir en entrenar al sistema con una base de datos que asocia outputs o productos con los respectivos inputs, haciéndole aprender la relación entre ambos para solucionar un problema dado. Un conocimiento previo no suele ser introducido en el algoritmo.

Pone el ejemplo concreto de un sistema destinado a estudiar la física de las torres que se derrumban en el que no se han introducido previamente las leyes de Newton, aunque el algoritmo las acaba deduciendo más o menos a base al análisis de los millones de ejemplos que se le han introducido en su fase de entrenamiento.

7. El deep learning actual no es capaz de distinguir claramente causalidad y correlación

Aunque el aprendizaje profundo aprende a establecer relaciones entre los insumos que recibe de información y el output o producto, no se puede hablar de que entienda la relación de causalidad. Por ejemplo, un sistema podría encontrar la correlación entre la altura de una persona y la riqueza en el uso del lenguaje –cuanto más alto es un niño, mejor habla-, pero no puede entender la relación de causa entre el desarrollo y crecimiento del chaval y su riqueza lingüística.

8. El deep learning actual cree vivir en un mundo estable

El aprendizaje profundo funciona mejor en un mundo estable con reglas precisas, como, por ejemplo, un juego de mesa, y no tan bien en entornos menos predecibles, como puede ser la evolución de los sistemas financieros.

9. El deep learning actual funciona bien como una aproximación, pero a veces sus soluciones no son fiables del todo

Por las razones expuestas anteriormente, el aprendizaje profundo funciona bien en determinadas situaciones, pero puede ser fácilmente engañado, por lo que hay que tratar con mucha cautela sus predicciones y dictámenes.

10. El deep learning actual es difícil de aplicar en la ingeniería

El autor apunta los riesgos de trabajar con el aprendizaje automático, pues considera que son sistemas que pueden funcionar en determinadas circunstancias, pero para los cuales es difícil garantizar que funcionarán en circunstancias alternativas con datos nuevos que pueden no parecerse a los que han sido utilizados en su entrenamiento. Esto impide que se pueda utilizar para desarrollar ingeniería robusta.

Una vez expuestos los retos, Gary Marcus plantea el riesgo de que, después de este periodo de grandes expectativas que han vivido las redes neuronales en los últimos años, la inteligencia artificial entre en otro periodo invernal, como el que vivió en 1970, cuando después de haberse generado grandes expectativas se consideró que era una tecnología demasiado frágil, estrecha y superficial para ser utilizada en la práctica fuera del marco experimental de los laboratorios.

Para Marcus, todo lo expuesto anteriormente no desacredita al aprendizaje profundo. Simplemente, no debe ser considerado como la solución universal y en cambio de ser contemplado como una herramienta estadística más, que debe ser utilizada junto a otras para lograr que el campo de la inteligencia artificial avance realmente, colmando todas las expectativas puestas en él.

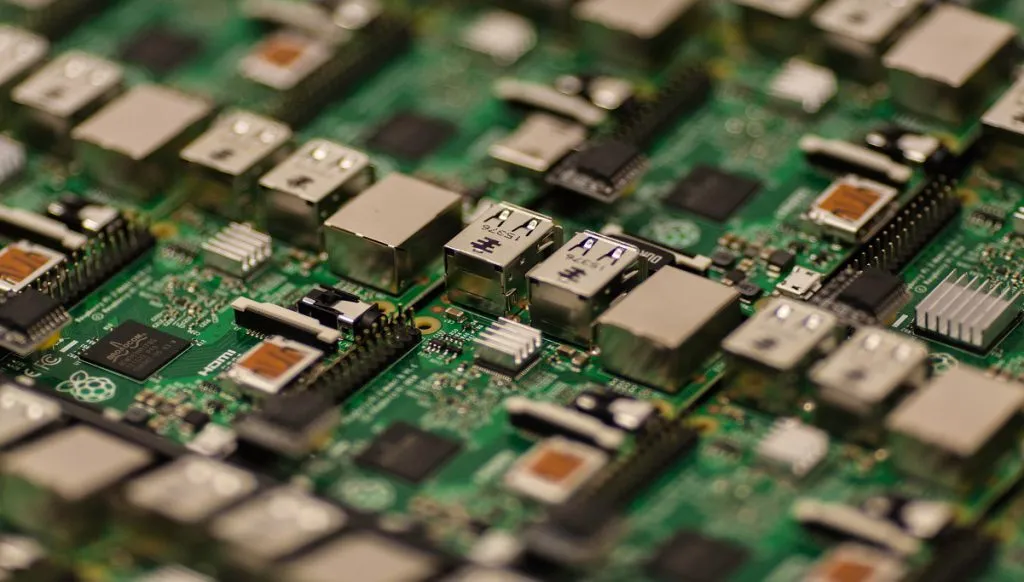

[ Fotografía de Craig Dennis (Pexels) ]

1Se puede consultar en https://www.nytimes.com/2016/12/14/magazine/the-great-ai-awakening.html?_ga=2.2228598.716335717.1538984073-299343837.1518693160

2Se puede consultar en https://arxiv.org/ftp/arxiv/papers/1801/1801.00631.pdf?_ga=2.16425328.716335717.1538984073-299343837.1518693160

Economista especializado en el estudio del impacto de la tecnología en la sociedad. Actualmente trabaja en el área de estudios y publicaciones de Fundación Telefónica.

Ver todos los artículos

Economista especializado en el estudio del impacto de la tecnología en la sociedad. Actualmente trabaja en el área de estudios y publicaciones de Fundación Telefónica.

Ver todos los artículos

Comentarios