El actual contexto de explosión de la información junto a la situación económica y de negocio obligan a las organizaciones a redefinir sus estrategias de gestión de la información.

Aunque el concepto de information explosion ha sido usado desde la década de 1960, el contexto actual con crecimiento exponencial de la información generada, la ubicuidad del acceso, la generación y la gestión, la hibridación de la información con el mundo físico y el uso masivo de información en la nube hacen que hoy podamos hablar de ‘infoexplosión’. Esta situación, junto a las nuevas necesidades que el contexto económico impone a las organizaciones, hace que estas deban replantearse su estrategia de gestión de la información. Y es en la implantación de dicha estrategia donde las herramientas de Big Data van a ser cruciales.

El presente artículo trata de identificar las tendencias dentro del contexto de ‘infoexplosión’ y las consecuentes transformaciones en la estrategia de gestión de la información de las organizaciones que conducirán a la adopción de soluciones de Big Data que permitan no solo manejar grandes cantidades de información, sino también integrar distintos formatos de la misma y, por supuesto, hacerlo en tiempo real.

Contexto de ‘infoexplosión’

Pocas cosas tienen en nuestra sociedad el impacto que tiene la información y las tecnologías para su creación, difusión y acceso. En los últimos años, la transformación sufrida por la información ha sido inmensa y esto solo parecen ser los primeros metros de un larguísimo maratón. Veamos algunas de las tendencias que lideran esta transformación de la información en lo que hemos denominado ‘infoexplosión’.

Crecimiento exponencial de la información generada

Un estudio publicado en la revista Science en mayo de 2011 (Hilbert y López, 2011) cifraba la información digital almacenada en el año 2007 en todo el mundo en más de 276.000 millones de gigabytes, unas 13.800 veces la información almacenada veinte años antes. Según este estudio, menos del 9 por ciento de toda esa información está almacenada en servidores. Lejos de frenarse, este crecimiento sigue acelerándose y se prevé que la información generada en 2020 sea cincuenta veces la generada en 2011 (Gantz, 2011). Esta es solo parte de la complejidad; además, el 90 por ciento de la información es información no estructurada y una parte altísima y creciente es generada por usuarios finales.

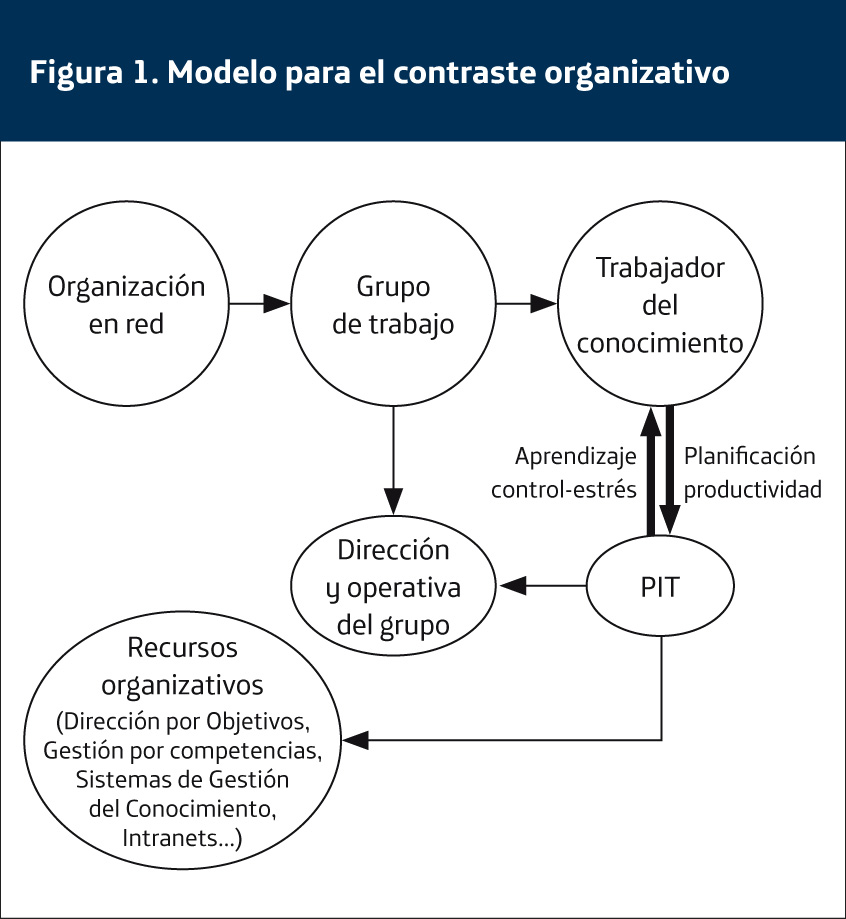

En junio de 2012, el CEO de Twitter anunciaba que la plataforma de microblogging había superado los 400 millones de tweets al día, doblando la cantidad de solo un año antes. 2013 empezó con nuevos récords para la plataforma. La figura 1 representa los tweets por segundo en la Nochevieja de 2012 en distintos sitios del mundo; en el instante del año nuevo en Japón y Corea, el tráfico alcanzó la cifra récord de 33.388 tweets por segundo y la plataforma china de microblogging Sina Weibo superó los 729.570 mensajes por minuto.

Pero el texto no es ni de lejos la parte más voluminosa de la explosión digital. YouTube afirma que cada minuto se suben a su plataforma 72 horas de vídeo. Es decir, necesitaríamos doce años seguidos sin parar a dormir ni a comer para ver todos los vídeos que se subieron ayer. Más de 3.000 fotografías se suben a Facebook cada segundo, unos 250 millones cada día, según cifras que la compañía hacía públicas a principios de 2012.

Pero la explosión de información no solo está en la Red; las organizaciones también se enfrentan al reto de trabajar con ingentes cantidades de información. Según un estudio del Mckinsey Global Institute, la media de información almacenada por empresa en 15 de los 17 sectores analizados superaba los 235 terabytes que almacena la Biblioteca del Congreso de los EEUU (Manjika et al., 2011).

Ubicuidad del acceso, la generación y la gestión

Acompañando a la explosión de la información, se ha producido una explosión en el acceso a la misma. En la ‘era post-PC’, el acceso multidispositivo desde cualquier lugar y en cualquier momento es una realidad y nos da a cada uno de nosotros la capacidad de «generar, reproducir y etiquetar contenido en la palma de nuestra mano y de distribuirlo globalmente con el acceso ubicuo y permanente a la Red» (García, 2012). En 2011 por primera vez en la Historia, se superarán los 2.000 millones de internautas en el mundo, pero también por primera vez más de la mitad de ellos accederán desde un dispositivo que no sea un PC (IDC, 2011).

Información en el mundo físico

La ya descrita tendencia hacia el acceso móvil a Internet es solo parte del cambio. De esta forma, el avance del acceso móvil y la proliferación de dispositivos avanzados podría enmarcarse en una transformación más profunda que distintos autores denominan de formas diferentes: web squared (O´Reilly, 2009), pervasive computing (Weiser, 1993) o everyware (Greenfield, 2006). Todas estas visiones tienen en común que el futuro de Internet es su ‘encuentro con el mundo real’ (O`Reilly, 2009).

Según el influyente trabajo de Weiser (1993), nos moveríamos hacia una ‘tercera ola’ en la historia de la computación. La primera, que él denomina la ‘era mainframe‘, estaba caracterizada por ordenadores compartidos por muchas personas, todas ellas expertas en tecnología. La segunda sería la ‘era del PC’, donde la relación persona/ordenador es unívoca y no hay que ser expertos para poder usarlos, aunque siguen siendo necesarios ciertos conocimientos para su manejo. La tercera sería en la que estamos entrando, la era de la computación ubicua, donde cada persona se relaciona con varios sistemas y las interfaces de relación son sencillas y transparentes (pensemos en los actuales desarrollos de interfaces táctiles o basadas en el habla). En esta tercera ola, la tecnología forma parte de nuestra vida cotidiana y se integra de manera transparente con el mundo físico. «Justo al contrario de lo que proponía la realidad virtual, personas dentro de un mundo generado por ordenador, la computación ubicua obliga a los sistemas a vivir en un mundo creado por los hombres» (Weiser, 1993). En este entorno en el que las cosas se conectan a Internet para generar y transmitir datos, la información podría verse como una piel digital que cubre el espacio físico, creando un espacio híbrido en el que personas y cosas están conectadas y en el que todo nuestro entorno puede ser concebido como una red (Varnelis, 2007). Es decir, no solo el acceso a la información es ubicuo, sino que también lo es su generación.

Proliferación del uso de la nube

Para completar este entorno en el que, como hemos visto, la información se genera y se accede a ella desde cualquier parte, es importante entender una última tendencia: la información es almacenada y gestionada en cualquier parte. El cloud computing parece hoy una tendencia imparable; según IDC, en 2015 el 20 por ciento de toda la información pasará por la nube en algún momento de su ciclo de vida y más del 10 por ciento se almacenará en la nube (IDC, 2011). Por tanto, la información en este nuevo entorno es generada, accedida, almacenada y gestionada en cualquier lugar, por lo que es location agnostic. Como veremos, ante este reto las organizaciones deben ser capaces de garantizar que sus arquitecturas de gestión de la información ofrecen el acceso óptimo a la misma, independientemente no solo del lugar donde se encuentra, sino también de la plataforma física (hardware) y lógica (software) que la albergue.

Los retos corporativos de la gestión de la información

Las organizaciones, públicas y privadas, tienen nuevas necesidades ligadas a la información y a las condiciones económicas de negocio que precisan una profunda reflexión sobre el rol que la información juega en las organizaciones y una transformación en las estrategias de gestión de la misma:

El mandamiento de la transparencia

La crisis financiera internacional vivida en los últimos años, y su consiguiente impacto en la confianza de los ciudadanos en las empresas y las Administraciones Públicas, han puesto de manifiesto la falta de transparencia de muchas de estas organizaciones. La transparencia va a ser una herramienta clave para recuperar la confianza y también para salir de la crisis. Transparencia entendida no solo como cumplimiento regulatorio, sino también como ‘abrir’ la información de la organización a clientes, empleados, proveedores y socios. La nueva necesidad de transparencia hace que las organizaciones estén desnudas (Tapscott y Ticoll, 2003), lo que en el corto plazo debería obligarlas a:

– Estar más en forma. En el entorno actual, el control absoluto de todos y cada uno de los procesos de la organización, su optimización y su alineamiento es una prioridad indiscutible. La gestión de la información tiene un rol fundamental en esta tarea. Llevar la información a la operación de los procesos va a permitir una mejor medida, una mayor optimización y un alineamiento global con los objetivos de la organización. Pero para ello es imprescindible disponer de arquitecturas de gestión de la información que permitan la integración de distintas fuentes de información y la operación en tiempo real. Ejemplos concretos de estas necesidades son las nuevas obligaciones de trazabilidad en la industria alimentaria o de almacenamiento de todas las interacciones con el cliente para empresas de marketing directo.

– Abrirse el kimono. La información genera confianza. Las organizaciones no deben tener miedo de usar la tecnología para hacer que la información fluya. Sus clientes quieren saber, sus empleados quieren saber, sus socios y proveedores quieren saber e informarles les hará mantener su confianza. Las organizaciones deben convertirse en fuentes de información para todos los agentes de su cadena valor. Ejemplos de esta política de abrirse el kimono serían, por ejemplo, las iniciativas de Open Government que ponen a disposición de los ciudadanos en formatos reutilizables la información pública o el denominado ‘periodismo de marca’ (Barciela, 2013), en el que grandes corporaciones a nivel global están creando sus propias agencias de noticias. Para lograr esto son necesarios mecanismos de gestión que permitan optimizar los flujos de información y el acceso a la misma por parte de los distintos agentes de la organización.

Nuevos modelos de toma de decisión

Otro efecto inmediato del contexto económico ha sido la presión para recortar aún más los tiempos de decisión. En un entorno complejo, las oportunidades se abren y se cierran en espacios de tiempo cortísimos y las organizaciones se ven obligadas a tomar decisiones casi en tiempo real. Pero este no es el único cambio en los procesos de toma de decisión; los directivos reconocen que necesitan cada vez más información para tomar estas decisiones y que muchas veces son conscientes de que carecen de la información que realmente necesitan. Pensemos por ejemplo en una decisión como la concesión de un crédito, el tiempo de decisión ha disminuido muchísimo, pero la cantidad de información -interna y externa y en múltiples formatos- que se considera necesaria ha aumentado enormemente.

Pero esto solo es el principio; transacciones financieras y ventas en tiempo real, medidas de sensores en las cadenas de fabricación, localización de nuestra flota de distribución u opiniones de los clientes en las redes sociales,… nuestras organizaciones manejan en la actualidad una cantidad ingente de información. Su análisis hace posible una nueva manera de tomar decisiones y gestionar las organizaciones que el profesor del MIT Erik Brynjolfsson define como DDD (Data Driven Decision), que permite a las organizaciones ganancias de productividad de entre un 5 y un 6 por ciento (Brynjolfsson y McAfee, 2011).

Organizaciones líquidas

El sociólogo Zygmunt Bauman utilizaba en Modernidad líquida (Bauman, 1999) la metáfora de los líquidos para describir la sociedad en la que vivimos. Si los sólidos conservan su forma y permanecen en el tiempo, los líquidos son informes y se transforman constantemente, son flujos. Las organizaciones no son ajenas a la sociedad donde viven y han de adaptarse a esta liquidez. Las organizaciones, como los líquidos, han de transformarse constantemente, extendiéndose con un centro cada vez menos evidente y unos límites más difusos. Los ejemplos de estas transformaciones están a la orden del día: procesos de fusión, como los que han vivido las entidades financieras españolas durante los últimos años; procesos de internacionalización o simplemente reorganizaciones, cada vez más frecuentes en las grandes compañías y en las Administraciones Públicas que también ven frecuentes cambios en sus funciones y responsabilidades. Las organizaciones deben ser líquidas y para ello han de transformar sus infraestructuras, hacerlas más ligeras, vaciar la mochila de los activos que cargan y sustituir estos por servicios de valor.

Siguiendo con el símil de los líquidos, igual que estos se evaporan a unas determinadas condiciones de temperatura, las organizaciones han de ser capaces de llevarse cosas a la nube cuando las condiciones de entorno se lo pidan. La transformación en organizaciones líquidas pasa por un nuevo modelo, no solo en la tecnología, sino también en las operaciones en general. Un modelo basado en servicios, en el que casi todo en una organización puede y debe gestionarse como tal. Las organizaciones líquidas trabajan en un modelo de ‘todo como servicio’ y la información ha de ser igualmente concebida como un servicio y no como un activo.

Una nueva estrategia de gestión de la información

Los cambios en la generación, el acceso y la gestión de la información y las nuevas necesidades de las organizaciones en el uso de la misma que hemos visto en las dos secciones anteriores precisan de una nueva estrategia organizativa de gestión de la información. En este último apartado vamos a hacer un recorrido por los nuevos factores que definirán una estrategia óptima de gestión de la información.

– Garantizar el flujo de la información: la información adecuada a la persona adecuada en el momento adecuado. Manuel Castells, en su imprescindible La sociedad red (2001), explicaba ya el espacio de flujos que la información define. La información no es hoy un activo a almacenar, sino un flujo a optimizar. No se trata de cuánta información tienes, sino de cuánta eres capaz de tener. La información se mueve y son sus flujos los que definen las relaciones entre personas, organizaciones o incluso entre Estados. Una óptima estrategia de gestión de la información debe manejar eficientemente estos flujos, garantizando que cada persona en la organización recibe la información que necesita en el momento adecuado, así como la integridad y la seguridad de la información en todo el flujo, definiendo roles y derechos sobre el uso de la misma. Disponer de herramientas que permitan contrastar la información, transformarla, reescribirla y enriquecerla es fundamental para garantizar el control del flujo informativo.

Para garantizar un flujo óptimo de la información, dado que el acceso, la generación y la gestión de la información son ubicuos es necesario ‘desacoplarla’ de su emplazamiento físico y lógico, permitiendo el acceso a la información independientemente no solo del soporte físico donde esté almacenada, sino también del software y su formato lógico.

Respecto al tiempo, las organizaciones se ven obligadas a tomar decisiones en intervalos de tiempo cada vez más cortos, con lo que las necesidades de información en tiempo real son cada vez mayores. Esto es especialmente crítico cuando se trata de inteligencia operativa, cada vez más utilizada para la optimización de procesos.

– Extender la gestión de la información. El 90 por ciento de la información que se genera en el mundo es no estructurada (Gantz, 2011); las organizaciones deben ser capaces de manejar información semiestructurada y no estructurada y ofrecer a todas las personas de la organización mecanismos para ordenar, mantener y utilizar este tipo de información.

Además, la información que una organización necesita no está solo dentro de la misma. Cada vez más, hay información de valor para la organización que está en la Red. Una óptima estrategia de gestión de la información debe permitir integrar esta información de la Red para ponerla a disposición de las personas que la necesiten en la organización con los menores costes de tiempo y dinero. Pero la Web es inherentemente grande, dinámica y heterogénea, por lo que son necesarios mecanismos de automatización y herramientas semánticas que ayudan de una forma fácil y fiable a extraer y ordenar información procedente de la Web y combinarla con información corporativa, para producir resultados de valor inmediatos.

– Reducir la complejidad y optimizar los costes. La complejidad de cómo y dónde se almacena la información debe ser completamente transparente para el usuario que solo quiere tener acceso a la información que necesita desde cualquier dispositivo, en cualquier momento y en cualquier lugar, independientemente de dónde esté la información. La capacidad de agregar fuentes, formatos y localizaciones en una visión única es crítica para una correcta estrategia de gestión de la información.

Además, para reducir la complejidad y los costes de almacenamiento y gestión es importante ser conscientes de que es imposible almacenar toda la información que la organización puede llegar a necesitar. Una estrategia de gestión de la información debe ser capaz de definir qué información se almacena y cómo se garantiza el acceso a la que no se ha almacenado. Por último, y en línea con lo anterior, para no incurrir en altos costes, una estrategia de gestión de la información debe minimizar las réplicas de datos y evitar bases de datos redundantes que no solo elevan los costes, sino que dificultan la gestión y reducen la flexibilidad. Replicar los datos solo cuando es necesario y evitar los desplazamientos de los mismos virtualizándolos permite ahorrar dinero y tiempo.

Conclusiones

El crecimiento exponencial de la información generada, la ubicuidad del acceso, generación y gestión de la misma, su hibridación con el mundo físico y el uso creciente de la nube definen un nuevo entorno de ‘infoexplosión’.

Este contexto, junto a las condiciones económicas, impone a las organizaciones nuevas necesidades de transparencia, toma de decisiones basada en información y flexibilización de sus infraestructuras.

Para dar respuesta a estas nuevas necesidades las organizaciones deben optimizar los flujos de información, extender la gestión de la misma y reducir la complejidad.

Bibliografía

Barciela, F. (2013, 24 de febrero). El boom del periodismo de marca. El País.

Brynjolfsson, E. y McAfee, A. (2011) Race Against The Machine: How the Digital Revolution is Accelerating Innovation, Driving Productivity, and Irreversibly Transforming Employment and the Economy. Boston: MIT.

Castells, M. (2001). La era de la información: economía, sociedad y cultura: la sociedad red. Madrid: Alianza.

García Cantero, J. (2012). Movilidad y cambio social: Identidad híbrida en la era ‘post-PC’. Telos, No. 89.

Gantz, J. et al. (2011). Digital Universe 2011. Boston: IDC

Greenfield, A. (2006). Everyware: The Dawning Age of Ubiquitous Computing. Berkeley: New Riders.

Hilbert, M. y López P. (2011, febrero). The World’s Technological Capacity to Store, Communicate, and Compute Information. Science Magazine.

IDC (2011). IDC Predictions 2011: Welcome to the new mainstream. Boston: IDC.

Manjika, J. et al. (2011). Big data: The next frontier for innovation, competition, and productivity. McKinsey Global Institute.

O’Reilly, T. y Battelle J. (2009). Web Squared: Web 2.0 Five Years On. Boston: O´Reilly Media.

Tapscott, D. y Ticoll, D. (2003). The Naked Corporation: How the Age of Transparency Will Revolutionize Business. New York: Free Press.

Varnelis, K. (2008). The Infrastructural City: Networked Ecologies in Los Angeles. New York: Actar.

Weiser, M. (1993). Some computer science issues in ubiquitous computing. Communications of the ACM, 36, 75-83.

Artículo extraído del nº 95 de la revista en papel Telos